AIに複雑なタスクを任せるときに必要なのは、“認識合わせ”

こんにちは、ヨシムラです。

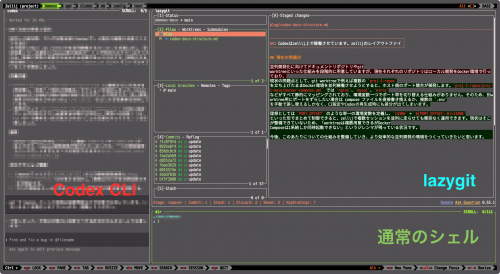

Codex のような生成AIを使っていて、

- 時間をかけたのに成果物がイメージと違う

- 修正を依頼したら、さらに方向がずれてしまう

- どうも待ち時間が長い割に期待通りにならない

と感じることは多いと思います。

実はこれは、AI特有の問題ではなく、人にタスクを渡すときにも普通に起こりうる現象です。

特に複雑な依頼ほど、背景や前提の共有が不十分だと、相手側が“空白を補う”形で判断をしてしまい、結果としてズレが生まれます。

これはAIも同じです。

むしろ、AIは推論能力が高い分、空白を多めに補完してしまうことがあります。

なぜズレが発生するのか

AIに複雑なタスクを投げたとき、

- 出力に時間がかかる

- 完成物の方向性がズレる

- 修正しても修正してもズレが埋まらない

という状態は、ほとんどが与えている文脈やスコープが曖昧なことが原因です。

AIは、与えられた情報の中から最も“ありえそう”と思われる推論を行います。

ここで文脈が欠けていると、AIが独自に補完した部分が、依頼者の意図と食い違ってしまうわけです。

つまり、ズレは “AIの能力不足” というより、

前提条件が合っていないことによる自然な結果として起きています。

認識を揃えることで、AIは安定して動く

AIが本来持っている性能を発揮させるには、タスクの最初の段階で認識を合わせることが重要です。

特に効果が高いのは以下のポイントです。

最初にプラン(計画)を出してもらう

「まず、このタスクをどう進めるべきかプランを作って」

と依頼すると、AIがタスクの計画を作成し、方針・前提の理解を示してくれます。

これによって、やり方のズレや見落としが早い段階で発見できます。

過去の成果物やパターンを参照する

「◯◯と同じ構成で作れそう?

必要なら特徴を比較してもらえる?」

といった形で“参照点”を共有すると、推論が安定します。

修正の影響範囲を先に確認する

「◯◯を修正した場合、どの部分に影響がある?」

「編集が必要になりそうなファイル名を列挙して」

修正前に“どこが動くか”を確認できれば、ズレの連鎖が起きにくくなります。

自分の認識を言語化して確認する

「このタスクは ×× のインターフェイスを実装する方針で考えている。

方針に問題がある部分はある?」

といった形で、自分が持っている前提を AI に照らし合わせると、齟齬に気づきやすくなります。

こうした小さな認識合わせは、そのまま依頼者自身の理解のチェックにもなるため、複雑なタスクで特に効果的です。

スコープを明確にすると、AIは無駄な推論をしない

「このファイルだけを修正してほしい」

「今回はアウトラインだけにして」

「追加調査は不要」

といった具合に範囲を制限すると、AIが余計な推論にリソースを使わず、結果のブレも減ります。

結局、AIの精度は“伝え方”で決まる

AIが期待通りの成果物を返せないとき、

能力の問題に見えることがありますが、実際には与えている文脈が足りないだけというケースが多くあります。

タスクに入る前に少し時間を使って、

- 背景

- 文脈

- ゴール

- スコープ

を整理して伝えるだけで、AIは安定して、意図通りに動いてくれます。

AIは「なんでも自動でやってくれる存在」ではなく、

前提が十分に揃ったときに最大のパフォーマンスを出す相棒です。

認識合わせのプロセスを自然に取り入れながら、

人とAIでより良い成果をつくっていけるチームを目指していきましょう。